Date

05.12.2022

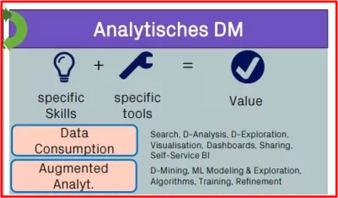

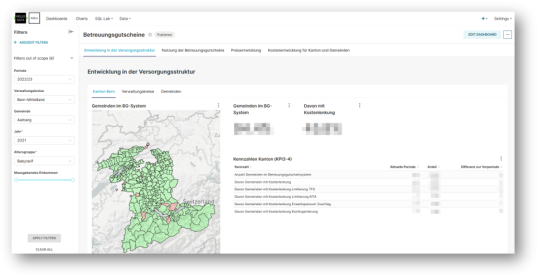

Quelle est l’efficacité des efforts d’intégration dans la promotion de la langue ? Dans ce contexte, les liens entre l’éducation et l’autonomie financière varient-ils d’une commune à l’autre ? Où utilise-t-on les bons de garde d’enfants et en quelle quantité ? Comment la structure des soins et l’évolution des coûts évoluent-elles dans les différents districts et communes ? La gestion analytique des données évalue et visualise les données en vue de pouvoir répondre à de telles questions. Nous permettons ainsi à nos clients de générer facilement une valeur ajoutée à partir de leurs données grâce à des outils, des fonctionnalités et des services appropriés.

Dans l’article De solides fondations pour votre data management, nous avons présenté en septembre « notre » maison du data management. Examinons maintenant d’un peu plus près le domaine de la gestion analytique des données : celle-ci repose sur la gestion efficace des données afin de pouvoir les utiliser pour procéder à des analyses. Cela comprend la mise à disposition des données ainsi que leur traitement et leur évaluation. Dans une entreprise, de nombreuses données différentes sont générées, par exemple par les clients, les finances, les produits et les processus. Pour que ces données puissent faire l’objet d’analyses, elles doivent d’abord être collectées, organisées et nettoyées. Sans ces travaux, il est difficile de réaliser des analyses et des évaluations pertinentes. Dans cet article, nous n’aborderons toutefois pas ces travaux.

Quelles sont les méthodes d’évaluation des données ?

Il existe différentes méthodes permettant d’évaluer les données. L’une des plus populaires et des plus utilisées est la statistique dite descriptive1*. Il s’agit d’une simple comparaison de chiffres, dans laquelle les valeurs respectives sont mises en relation les unes avec les autres. Cela permet par exemple d’estimer des ordres de grandeur, de calculer des valeurs moyennes, d’identifier des tendances et d’établir des corrélations.

De ces valeurs chiffrées découle ensuite un autre aspect important de la gestion analytique des données : la visualisation des constats obtenus. Les résultats de l’analyse des données doivent être présentés de manière à ce qu’ils soient compréhensibles pour toutes les personnes concernées. C’est la seule façon de les utiliser efficacement pour prendre les bonnes décisions.

« Proof of the pudding »

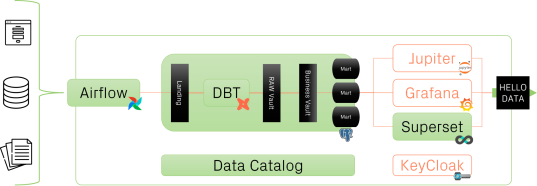

Chez Bedag, nous tirons le meilleur parti des outils de traitement des données les plus récents et les plus disponibles, et nous utilisons également des produits ouverts au code source. Les trois logiciels « Apache Airflow », « Data Build Tool DBT » et « Apache Superset » s’intègrent parfaitement les uns aux autres et sont donc en mesure d’optimiser rapidement les processus d’analyse de données d’une entreprise.

Les possibilités de libre-service sont centrales pour le processus d’analyse des données. Nous faisons appel pour cela à « Superset ». Cet outil est facile à utiliser et très intuitif, ce qui permet au client de créer ses propres visualisations et tableaux de bord. Il peut ainsi réaliser ses analyses de données propres à l’entreprise sans l’aide de Bedag.

Airflow permet d’orchestrer l’exécution de graphes acycliques dirigés (DAG) et de les présenter de manière claire. Les DAG sont définis dans un script Python et se composent de tâches qui sont exécutées dans un ordre défini. Une tâche est une ligne de commande, par exemple l’exécution d’un autre script Python ou de commandes Bash. Airflow présente en détail l’exécution des DAG et de leurs tâches, avec l’état d’exécution, les moments d’exécution, la durée d’exécution et plus encore. Cela peut être visualisé sous forme de tableau ou de calendrier.

Nous utilisons ELT (extract-load-transform) au lieu de l’habituel ETL afin de:

• charger le moins possible les systèmes sources (souvent des bases de données productives),

• pouvoir effectuer les transformations au sein du datawarehouse (DWH) indépendamment de l’extraction et du chargement et

• pouvoir gérer les transformations en dbt avec SQL de manière lisible et avec un contrôle de version.

Dans DBT, toutes les transformations effectués au sein du DWH (Landing Zone → Raw Data Vault → Business Data Vault → Use-case-driven Data Mart) sont définies par des modèles de données et consistent en des scripts SQL. Chaque modèle de données génère une table ou une vue dans le DWH.

DBT consiste en la combinaison de SQL et de Jinja et offre ainsi quelques fonctionnalités qui facilitent le développement et la maintenance des modèles de données.

Avec Superset, nous disposons d’un outil puissant destiné à l’analyse et à la visualisation des données. Celui-ci convient aussi bien comme outil BI en libre-service que pour le développement individuel de tableaux de bord. Dans Superset, les données d’une base de données (dans notre cas, les data marts spécifiques au projet du DWH) peuvent être exposées directement en tant qu’ensembles de données ou importées individuellement à l’aide du SQL Lab intégré àgrâce à des requêtes SQL personnalisées. Les ensembles de données peuvent être préparés et représentés visuellement dans des graphiques. Divers types de graphiques sont disponibles, comme les barplots, les séries chronologiques, les tachymètres, les graphiques en réseau, les visualisations cartographiques (basées sur deck.gl). Les graphiques peuvent à leur tour être intégrés dans des tableaux de bord et y être organisés et présentés de manière visuellement attrayante à l’aide d’éléments de style tels que des onglets et des grilles d’agencement. De plus, les tableaux de bord offrent différentes options de filtrage qui permettent aux utilisateurs d’interagir avec les graphiques et d’explorer ainsi les ensembles de données sous-jacents.

Une approche résolument itérative

Les résultats montrent que notre approche de la gestion des données est efficace et qu’elle génère rapidement des avantages pour les clients. Pour développer la gestion analytique des données, nous procédons de manière itérative et testons chaque sous-fonctionnalité sur la base de tâches concrètes définies par notre client avant de nous atteler au développement de la fonctionnalité suivante. Nous nous assurons ainsi que « le moteur fonctionne vraiment après l’assemblage de tous les composants ».

Les retours positifs des clients confirment que cette approche est efficace. La prochaine étape consistera probablement à connecter d’autres applications spécialisées au moyen de connecteurs Airbyte. Vous en saurez plus au printemps 2023 en lisant nos Actualités.

-------------------------------------------------------------------------------------------------------------------

1* La statistique descriptive (ou descriptive) a pour objectif de présenter et d’organiser de manière claire des données empiriques (par exemple des résultats issus d’expériences réalisées) à l’aide de tableaux, de chiffres clés (également appelés mesures ou paramètres) et de graphiques. Cela est particulièrement utile lorsque les données sont nombreuses, car il n’est pas facile d’en avoir une vue d’ensemble.

2022-09-20 10:30:59