Datum

05.12.2022

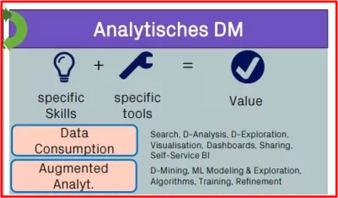

Wie effektiv sind Integrationsbemühungen in der Sprachförderung? Sind dabei die Zusammenhänge zwischen Bildung und finanzieller Selbstständigkeit in einzelnen Gemeinden unterschiedlich? Wo werden wie viele Kinderbetreuungsgutscheine genutzt? Wie entwickelt sich die Versorgungsstruktur und die Kostenentwicklung in einzelnen Gemeinden und Verwaltungskreisen? Damit solche Fragen beantwortet werden können, wertet das analytische Datenmanagement Daten aus und visualisiert diese. So ermöglichen wir unseren Kunden, mit entsprechenden Tools, Funktionalitäten und Services, einfach einen Mehrwert aus ihren Daten zu generieren.

Im Beitrag Ein starkes Fundament für Ihr Datenmanagement haben wir im September «unser» Datenmanagementhaus vorgestellt. Nun wollen wir den Bereich des analytischen Datenmanagements etwas genauer beleuchten: Der Kern des analytischen Datenmanagements ist die effektive Verwaltung von Daten, um sie für Analysen nutzen zu können. Dazu gehört die Bereitstellung der Daten sowie deren Aufbereitung und Auswertung. In einem Unternehmen werden viele verschiedenartige Daten generiert – beispielsweise durch Kunden, Finanzen, Produkte und Prozesse. Damit diese Daten für Analysen genutzt werden können, müssen sie zunächst gesammelt, organisiert und bereinigt werden. Ohne diese Arbeiten ist es schwer, aussagekräftige Analysen und Auswertungen durchzuführen. Auf diese Arbeiten gehen wir an dieser Stelle jedoch nicht ein.

Welche Methoden gibt es zur Auswertung von Daten?

Es gibt verschiedene Methoden, mit denen Daten ausgewertet werden können. Eine der beliebtesten und am häufigsten verwendete ist die sogenannte deskriptive Statistik 1*. Dabei handelt es sich um einen reinen Zahlenvergleich, bei dem die jeweiligen Werte miteinander in Bezug gesetzt werden. Damit lassen sich zum Beispiel Grössenordnungen abschätzen, Mittelwerte berechnen, Trends erkennen und Zusammenhänge herstellen.

Aus diesen Zahlenwerten folgt dann ein weiterer wichtiger Aspekt des analytischen Datenmanagements: die Visualisierung der gewonnenen Aussagen. Die Ergebnisse der Datenanalyse müssen so aufbereitet werden, dass sie für alle Beteiligten verständlich sind. Nur so können sie effektiv genutzt und mit ihnen die richtigen Entscheidungen getroffen werden.

«Proof of the pudding»

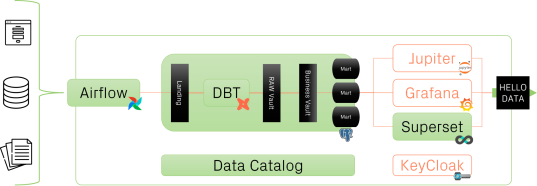

Bei der Bedag holen wir das Beste aus den aktuellsten verfügbaren Datenverarbeitungstools und setzen auch Quellcode-offene Produkte ein. Die drei Softwareprodukte «Apache Airflow», «Data Build Tool DBT» und «Apache Superset» spielen nahtlos ineinander und sind darum in der Lage, die Datenanalyseprozesse eines Unternehmens rasch zu optimieren.

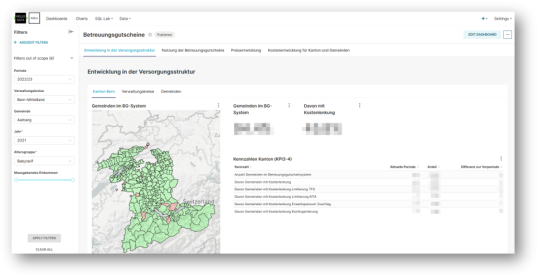

Zentral für den Datenanalyseprozess sind Selfservicemöglichkeiten. Wir nutzen dazu Superset. Es ist einfach zu bedienen und sehr intuitiv, was dem Kunden ermöglicht, eigene Visualisierungen und Dashboards zu erstellen. So kann er ohne Hilfe der Bedag eigene Analysen von unternehmenseigenen Daten durchführen.

Mit Airflow wird die Ausführung von Directed Acyclic Graphs (DAG) orchestriert und übersichtlich dargestellt. DAG werden in einem Python-Skript definiert und bestehen aus Tasks, die in einer festgelegten Reihenfolge ausgeführt werden. Ein Task ist ein Command-Line-Befehl, z.B. die Ausführung eines weiteren Python-Skripts oder Bash-Commands. Airflow stellt die Ausführung von DAG und deren Tasks detailliert dar mit Ausführungsstatus, Ausführungszeitpunkten, Ausführungsdauer und mehr. Dies kann als Tabelle oder als Kalender visualisiert werden. Wir verwenden ELT (extract, load, transform) statt des üblichen ETL, um:

• die Quellsysteme (oft produktive Datenbanken) möglichst wenig zu belasten,

• die Transformationen innerhalb des Datawarehouse (DWH) unabhängig von Extraction und Load ausführen zu können und

• die Transformationen in DBT mit SQL lesbar und versionskontrollierbar führen zu können.

In DBT werden alle Transformationen innerhalb des DWH (Landing Zone → Raw Data Vault → Business Data Vault → Use-case-driven Data Mart) durch Datenmodelle definiert und bestehen aus SQL-Skripts. Jedes Datenmodell generiert eine Tabelle oder einen View im DWH. DBT besteht aus der Kombination von SQL mit Jinja und bietet dadurch einige Features, welche die Entwicklung und Unterhaltung von Datenmodellen erleichtern.

Mit Superset haben wir ein mächtiges Tool für die Datenanalyse und Datenvisualisierung. Dieses eignet sich sowohl als Self-Service-BI-Tool als auch für die Individualentwicklung von Dashboards. In Superset können Daten aus einer Datenbank (in unserem Fall die projektspezifischen Data Marts des DWH) direkt als Datasets exponiert werden oder anhand des eingebauten SQL Labs durch massgeschneiderte SQL-Abfragen individuell importiert werden. Datasets können in Charts visuell aufbereitet und dargestellt werden. Es stehen diverse Chart-Typen zur Verfügung, z.B. Barplots, Timeline-Series, Tachometer, Netzwerk-Graphs, Kartenvisualisierungen (deck.gl-basiert). Die Charts wiederum können in Dashboards integriert und dort mit Stilelementen wie Register-Tabs und Anordnungsraster visuell ansprechend organisiert und präsentiert werden. Zudem bieten Dashboards unterschiedliche Filteroptionen, mit denen Benutzer mit Charts interagieren und so die dahinterliegenden Datasets explorieren können.

Durch den Proof of Concept Kibon (Dashboard Kinderbetreuungsbon) und das Pilotprojekt MoMi (Monitoring Migration), die wir gemeinsam mit der Gesundheits-, Sozial- und Integrationsdirektion des Kantons Bern (GSI) durchgeführt haben, konnten wir die Datenanalyse und Datenrückverfolgbarkeit (Data Lineage) für unsere Kunden auf ein neues Level heben.

Konsequent iteratives Vorgehen

Die Resultate zeigen, dass unser Konzept für das Datenmanagement aufgeht und rasch Kundennutzen erzeugt. Für die Entwicklung des analytischen Datenmanagements gehen wir iterativ vor und prüfen jede Teilfunktionalität anhand von konkreten Aufgabenstellungen durch unseren Kunden, bevor wir uns an die Weiterentwicklung der nächsten Funktionalität machen. So stellen wir sicher, dass «der Motor nach dem Zusammensetzen aller Bauteile dann auch wirklich funktioniert».

Das positive Kundenfeedback bestätigt, dass dieses Vorgehen zielführend ist. Als Nächstes folgt voraussichtlich die Anbindung weiterer Fachapplikationen mittels Airbyte-Konnektoren. Mehr dazu werden Sie im Frühling 2023 in unseren News erfahren.

-------------------------------------------------------------------------------------------------------------------

1* Die deskriptive (auch: beschreibende) Statistik hat zum Ziel, empirische Daten (z.B. Ergebnisse aus Experimenten) durch Tabellen, Kennzahlen (auch: Masszahlen oder Parameter) und Grafiken übersichtlich darzustellen und zu ordnen. Dies ist vor allem bei umfangreichem Datenmaterial sinnvoll, da dieses nicht leicht überblickt werden kann.

2022-09-20 10:30:59